“太忙了。”从春节到元宵节,人工智能芯片和计算能力制造商的工程师们一刻也不忙。忙碌的背后是一条叫做DeepSeek的“鲶鱼”。它的低计算能力、高性能、开源等特点...

Deepseek开始射击!国产芯片开启辅助:卷适配、卷落地、卷性价比高

| 后台-插件-广告管理-内容页头部广告(手机) |

“太忙了。”从春节到元宵节,人工智能芯片和计算能力制造商的工程师们一刻也不忙。忙碌的背后是一条叫做DeepSeek的“鲶鱼”。它的低计算能力、高性能、开源等特点,使原本卡在计算能力“瓶颈”中的国内人工智能再次充满

“太忙了。”从春节到元宵节,人工智能芯片和计算能力制造商的工程师们一刻也不忙。

忙碌的背后是一条叫做DeepSeek的“鲶鱼”。它的低计算能力、高性能、开源等特点,使原本卡在计算能力“瓶颈”中的国内人工智能再次充满想象力。

从新年的第四天到新年的第十天,十多家国内人工智能芯片和计算能力企业加入了“朋友圈”,工程师们忙于适应和服务;现在,问这些企业在忙什么,回复可能是统一的部署。

据了解,目前,该行业正从DeepSeek的适应过渡到部署和应用。一方面,企业迎来了大量的用户咨询,充分响应用户的需求。另一方面,它也在建立一台智能计算机集成机,以加快人工智能应用程序的实施。”Deepseek真的可以成为生产力工具,满足应用程序着陆需求的大型模型。预计2025年将爆发大型模型的应用程序着陆。”业内人士表示。

在过去的两年里,ChatGPT带动了计算能力行业,并将英伟达送上了“国王宝座”。国内计算能力制造商正在努力寻找出路。现在,DeepSeek已经打开了一个洞。天空已经到来,但国内计算能力能否飙升还有待测试。

据业内人士分析,DeepSeeek推理计算能力需求激增,行业可能迎来新一轮洗牌、未来或性价比之争。

2月13日,DeepSeek概念股下午再次上涨,宏景科技20cm涨停,优刻得(688158.SH)、弘信电子(300657.SZ)、并行科技(839493.BJ)涨超10%。

紧急“适配”

实际上,国内计算能力厂商的“适应潮”还在继续。

例如,早在2月4日,华为就宣布与硅基流动合作,推出基于华为云升腾云服务的DeepSeekR1/V3推理服务。但直到2月12日,华为云才再次宣布,DeepSeek V3/R1满血版上线。

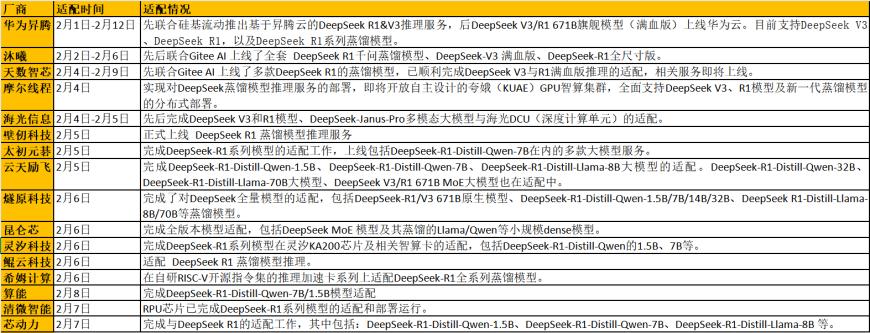

截至目前,虽然已有15多家芯片制造商适应了DeepSeek模型,但根据时代财经的不完全统计,明确宣布了DeepSeek模型的适应 不到一半的R1和V3原版模型。

图源:时代财经不完全统计梳理

大多数企业声称可以在“几小时”和“一天”内快速完成适应,但大多数只是DeepSeekek R1系列蒸馏模型,原版或“满血版”模型适应仍在进行中。

云天励飞(688343.SH)副总裁、芯片业务线总经理李爱军告诉时代财经,在适应上线的过程中,DeepSeek模型可以分为两类,一类是基于DeepSeek R1蒸馏了一些参数小的模型,包括1.5B、7B、14B和70B等大型模型,这些蒸馏模型的原始模型是通义问题和LLAMA,所以最初可以支持通义问题和LLAMA模型平台,基本上可以适应这些蒸馏模型,工作量相对较小,企业一般需要一周左右才能适应。

另一种是Deepsekek DeepsekekV3 R1的原始模型是DeepSeek自主开发的原始生态MOE模型,其参数达到671B,包括MLA等新算子,测试芯片适应超大型MOE架构、支持新算子、稀疏MOE模型的执行效率等能力。

最大的困难之一是模型本身的参数很大。”目前,国内HBM(高带宽存储器)芯片的容量并不大,16GB用于推理人工智能计算场景、32GB甚至64GB的HBM容量被认为是一个更大的配置。但即使使用64GB芯片运行671B参数的大型模型,也至少需要11个参数才能将参数加载到芯片中×只有64GB的芯片才能勉强放下这个模型。这也意味着单卡无法解决问题,涉及到卡与卡之间的互联能力和效率。”李爱军说,因此,适应的时间取决于每个家庭的基础。如果基础好,投资大,一两周就能完成适应。如果技术次于此,可能需要两三周左右或更长时间,有些甚至无法适应。

昆仑芯科技还表示,从理论上讲,各种大型模型的传统模型和传统网络可以直接运行。然而,不可避免地会出现特殊的计算器和规模,这需要投入人力进行有针对性的调试。运行只是基础。在后期阶段,它涉及不同的后端硬件、不同的计算实现、不同的相应软件版本等因素。精度对齐和性能对齐也需要人力介入进行有针对性的适应。

然而,一些业内人士向《纽约时报》财经透露,由于DeepSeek本身是开源的,在适应过程中不需要授权。虽然许多平台目前正在适应该模型,但这种适应可能并不是真正意义上的“访问”。“真正的访问是,DeepSeek使用智能计算中心提供云服务,但很少有制造商真正与DeepSeek达成这种合作,可能只有一两家。”

部署和落地

除了适应,更重要的是部署。

近期并行科技(839493.BJ)、许多企业,如壁崖科技、摩尔线程和昆仑核心科技,都向时代财经透露,他们正忙于为客户部署DeepSeek模型。

“部署是将大型模型转化为生产力的必要步骤。”半导体董事长陈伟解释说,部署相当于在用户的生产环境中安装模型,并与客户的生产环境建立联系。

时代金融在国内计算能力运营商的产品交流小组中观察到,许多用户正在询问如何导入和设置API、如何整合相关服务,有人咨询为什么DeepSeek模型接入后运行速度慢。

摩尔线程相关技术负责人2月12日告诉时代财经:“该行业确实处于模型应用的关键阶段。”。

时代金融了解到,近期行业密集适应DeepSeek系列模型后,很多厂商开始寻求落地应用,智算一体机的硬件部署形式浮出水面。

摩尔线程表示,公司正在与雪浪云联合打造“软硬件紧耦合”大型训推一体机——雪浪MindCenter X100已成功部署DeepSeek-R1-Distill-Qwen(适配1.5B、7B、14B、32B)推理服务。

一位业内人士感慨地说:“一体机业务将是今年的大机遇,离线需求太大。”。

“前段时间大家都在适应。适应之后呢?我们希望在某些领域实现真正的应用。”壁伦科技相关负责人告诉《纽约时报》财经,壁伦科技与ZTE、浙江大学上海高等研究所、伊迪科技联合推出了智海人工智能教育一体机。本产品实现了国内计算能力与DeepSeek的适应,以及知识课程、培训项目、智能身体等教学工具的设计和开发,形成了人工智能通识课程、专业课程、实践培训等综合解决方案。

2月11日,中国电信(601728).SH)和中国移动(6009411).SH)两大电信运营商也分别推出了天翼云和移动云智能计算一体机-DeepSeek版。

根据移动云的官方消息,智能计算机一体机只是基于移动云边缘智能站计算能力基础的小型独家云,专门为企业定制。它重用了边缘智能站的产品技术,以及统一的运维和快速交付,解决了企业的问题 AI 对数据安全的担忧也可以提高AI应用开发的效率。

此外,京东云和联想(0992.HK)、科华数据(002335.SZ)、中国长城(00066).SZ)、天融信(002212.SZ)等待所有企业正式宣布发布DeepSeek智算一体机。

行业还是迎洗牌?

DeepSeek火了,顺便赢得了国产计算能力,但也带出了一系列问题。DeepSeek时代需要什么样的计算能力?DeepSeek将如何改变当前计算能力市场的战局?

此前,DeepSeek似乎计算能力紧张。2月6日,DeepSeek暂停API(界面)充值服务,DeepSeek正式解释为服务器资源短缺。2月9日,DeepSeek调整收费标准,每100万tokens的价格为0.5元(缓存命中)和2元(缓存未命中),而tokens的输出价格为每100万8元。在优惠期内,DeepSeek-V3输入tokens的费用为每百万0.1元(缓存命中)和1元(缓存未命中),输出tokens为每百万2元。

李爱军认为,当DeepSeeek模型的性能足够强大,未来可能继续开源战略时,企业可以直接使用它进行应用,而不是重新培训基本模型。因此,未来推理侧的计算能力需求将大规模爆发。

他说,在模型培训环节追求极端性能,即使GPU价格很高,企业也会毫不犹豫地购买。一旦进入推理环节,行业的焦点将成为成本效益,因为推理应该一直使用,GPU芯片在推理时代并不具有成本效益,而专门为推理场景设计的ASIC芯片将有很大的机会。

“训练芯片和推理芯片在思维逻辑上有很大的不同。训练芯片大多与CUDA架构兼容,采用GPU架构,云天励飞等推理芯片,神经网络处理架构大多采用。从训练芯片到推理芯片,市场对芯片的要求和商业模式将发生很大变化。”李爱军推测,芯片行业未来可能面临新一轮洗牌。

摩尔线程相关技术负责人认为,从训练方面来看,Scaling Law规模定律仍然有效,模型迭代将加快,对国内高质量培训计算能力的需求不会减少。从长远来看,扩大模型参数(如GPT-5)和培训方法创新(如MoE)仍将促进培训计算能力需求的增长;从推理的角度来看,随着生成人工智能应用程序(如人工智能CC)的实施、智能身体和垂直行业模型)将带来大量的碎片化推理需求,市场规模可能超过培训。

该技术负责人表示,在短期内,国内GPU制造商应保持培训芯片的持续迭代,如最佳支持FP8,以确保技术不脱节,并通过推理芯片快速切入商业场景。从长远来看,针对“培训推广一体化”架构,通过统一计算平台降低客户切换成本,最终实现独立生态中培训推理的协同增长。

至于Deepseek的冲击波是否会影响大洋彼岸的英伟达,陈伟表示,他没有看到Depseek对英伟达的直接负面影响,但如果Depseek导致更广泛、更严格的禁运,可能会减少英伟达GPU的销量。

“事实上,每一代模型的进步都意味着在相同的计算能力下,模型的精度发生了变化。在过去,模型的进步并没有导致英伟达的市场价值下降。对于像deepseek这样的大型模型,由于参数巨大,存储成本需要更低。降低成本和提高效率是摆在每个制造商面前的关键。”陈伟说。

(来源金融界)| 后台-插件-广告管理-内容页尾部广告(手机) |

标签:

相关文章